醫(yī)學(xué)大模型

一 華駝(HuaTuo)大模型HuaTuo是經(jīng)過中文醫(yī)學(xué)指令微調(diào)(Instruct-tuning) 的LLaMA-7B模型,在微調(diào)后提高了LLaMA在醫(yī)療領(lǐng)域的問答效果

一 華駝(HuaTuo)大模型

HuaTuo是經(jīng)過中文醫(yī)學(xué)指令微調(diào)(Instruct-tuning) 的LLaMA-7B模型,在微調(diào)后提高了LLaMA在醫(yī)療領(lǐng)域的問答效果(存在疑問,如何進(jìn)行評價(jià)的)。

1 數(shù)據(jù)

采用公開和自建的中文醫(yī)學(xué)知識(shí)庫,并利用GPT3.5接口圍繞醫(yī)學(xué)知識(shí)庫構(gòu)建問答數(shù)據(jù)構(gòu)建了中文醫(yī)學(xué)指令數(shù)據(jù)集。數(shù)據(jù)集分為instruction、input和output三部分,格式如下:

{"instruction": "一個(gè)患者的卵巢小細(xì)胞癌轉(zhuǎn)移至其它部位,是否有必要進(jìn)行手術(shù)治療?"n "input": "", n"output": "當(dāng)卵巢小細(xì)胞癌轉(zhuǎn)移至其它部位時(shí),手術(shù)治療的效果可能不理想,因此一般不推薦進(jìn)行手術(shù)治療。針對轉(zhuǎn)移病灶,可以采用化療、放療等治療手段進(jìn)行綜合治療。"}

此外收集了2023年關(guān)于肝癌疾病的中文醫(yī)學(xué)文獻(xiàn),利用GPT3.5接口圍繞醫(yī)學(xué)文獻(xiàn)多輪問答數(shù)據(jù)。數(shù)據(jù)集分為instruction、input和output三部分,instruction又包括user和bot兩部分,格式如下:

{"instruction": " <user>: 我聽說免疫療法是治療晚期肝癌的一種很有效的方法,真的嗎? n<bot>: 是的,免疫療法是一種新興的治療方法,它可以提高人體免疫系統(tǒng)對癌細(xì)胞的反應(yīng)能力。對于晚期肝癌患者,免疫療法已證明具有很高的治療效果。 n<user>: 但是,這是否適用于所有的肝癌患者?", n"output": "不是所有的肝癌患者都適合進(jìn)行免疫療法。根據(jù)患者的臨床表現(xiàn)和病情,醫(yī)生會(huì)對患者進(jìn)行評估,從而選擇最適合的治療方案。",n "input": ""}

2 訓(xùn)練

2.1 訓(xùn)練資源需求

在一張A100-SXM-80GB顯卡上進(jìn)行了訓(xùn)練,訓(xùn)練總輪次10輪,耗時(shí)約2h17m。batch_size=128的情況下顯存占用在40G左右。預(yù)計(jì)3090/4090顯卡(24GB顯存)以上顯卡可以較好支持,根據(jù)顯存大小來調(diào)整batch_size。(稍后試試)

2.2 微調(diào)代碼

常規(guī)Lora訓(xùn)練流程。(之后有時(shí)間寫分析)

3 推理

推理方式分為三種,區(qū)別在于加載的LoRA權(quán)重不同和是否支持多輪。加載的LoRA權(quán)重分為對LLaMA和Alpaca進(jìn)行指令微調(diào)的LoRA權(quán)重文件,并可以進(jìn)一步劃分為基于醫(yī)學(xué)知識(shí)庫和醫(yī)學(xué)文獻(xiàn)的LoRA權(quán)重。

#基于醫(yī)學(xué)知識(shí)庫nbash ./scripts/infer.shnn#基于醫(yī)學(xué)文獻(xiàn)n#單輪nbash ./scripts/infer-literature-single.shnn#多輪nbash ./scripts/infer-literature-multi.sh

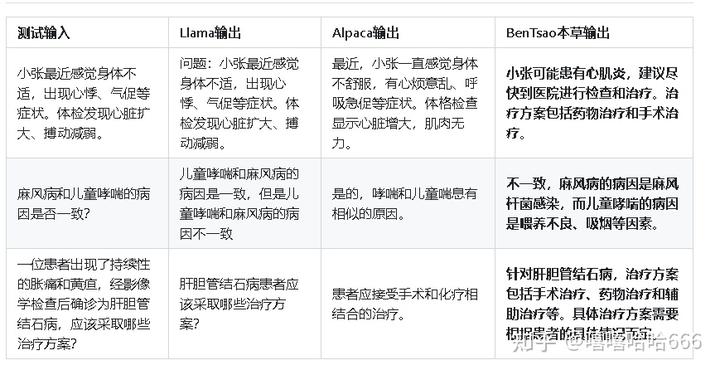

4 實(shí)驗(yàn)結(jié)果

方案中的幾個(gè)測試用例,好壞無法按照幾個(gè)案例來評價(jià),應(yīng)該進(jìn)行更多測試。

沒擴(kuò)充llama詞表不知道是否有影響。

項(xiàng)目由哈爾濱工業(yè)大學(xué)社會(huì)計(jì)算與信息檢索研究中心健康智能組完成,項(xiàng)目鏈接:

SCIR-HI/Huatuo-Llama-Med-Chinese: Repo for BenTsao [original name: HuaTuo (華駝)], Llama-7B tuned with Chinese medical knowledge. 本草(原名:華駝)模型倉庫,基于中文醫(yī)學(xué)知識(shí)的LLaMA模型指令微調(diào) (github.com)二 DoctorGLM

基于 ChatGLM-6B的中文問診模型。

項(xiàng)目地址:

xionghonglin/DoctorGLM: 基于ChatGLM-6B的中文問診模型 (github.com)三 MedicalGPT-zh

基于ChatGLM-6B LoRA 16-bit指令微調(diào)的中文醫(yī)療通用模型。

項(xiàng)目地址:

GitHub - MediaBrain-SJTU/MedicalGPT-zh: MedicalGPT-zh:一個(gè)基于ChatGLM的在高質(zhì)量指令數(shù)據(jù)集微調(diào)的中文醫(yī)療對話語言模型四 ChatDoctor

英文版,一個(gè)基于LLaMA的在醫(yī)療領(lǐng)域的大模型。

項(xiàng)目地址:

Kent0n-Li/ChatDoctor (github.com)五 MedQA-ChatGLM

GitHub - WangRongsheng/MedQA-ChatGLM: ? 基于真實(shí)醫(yī)療對話數(shù)據(jù)在ChatGLM上進(jìn)行LoRA、P-Tuning V2、Freeze、RLHF等微調(diào),我們的眼光不止于醫(yī)療問答六 visual-med-alpaca

多模態(tài)大模型

https://github.com/WangRongsheng/XrayGLM七 LMFlow

英文版,基于PubMedQA和MedMCQA構(gòu)建了instruction數(shù)據(jù)集,使用8*A100,微調(diào)約16個(gè)小時(shí)得到LLaMA-33B(LoRA)模型,在醫(yī)療問題上的效果優(yōu)于ChatGPT。

項(xiàng)目地址:

OptimalScale/LMFlow: An Extensible Toolkit for Finetuning and Inference of Large Foundation Models. Large Model for All. (github.com)八 Baize

英文版。模型調(diào)優(yōu)的數(shù)據(jù)來自Quora和Medical對話,基于LLaMA-7B微調(diào)得到。

項(xiàng)目地址:

project-baize/baize-chatbot: Let ChatGPT teach your own chatbot in hours with a single GPU! (github.com)九 Med-PaLM

英文版,Google的工作。在PaLM的基礎(chǔ)上加了instruction prompt tuning,具體工作見《Large Language Models Encode Clinical Knowledge》,不是很常見。

項(xiàng)目地址:

2212.13138.pdf (arxiv.org)十 Visual-Med-Alpaca

英文版,在文本側(cè),基于gpt-3.5 turbo和human共同合作構(gòu)建的指令數(shù)據(jù)集。支持多模態(tài)的問答

項(xiàng)目地址:

Visual Med-Alpaca參考鏈接:

中文醫(yī)療大模型的2W1H分析